- Published on

آشنایی با LLMها، RAG، ایجنتهای هوش مصنوعی، Tool Calling و Model Context Protocol (MCP) در صنعت پرداخت

- نویسندگان

- نام

- هومن امینی

- توییتر

- @HoomanAmini

مقدمه

در سالهای اخیر، پیشرفتهای چشمگیری در حوزهی هوش مصنوعی رخ داده که فضای فناوری را به شکلی بیسابقه دگرگون کرده است.

در کتاب «The Coming Wave» نیز به ظهور موجی از نوآوری اشاره شده که قادر است هر جنبهای از زندگی و کسبوکار، از جمله صنعت پرداخت را متحول کند.

پنج مفهوم کلیدی که این پیشرفتها را رقم زدهاند عبارتاند از:

- مدلهای زبانی بزرگ (LLM)

- بازیابی و تولید ترکیبی (RAG)

- ایجنتهای هوش مصنوعی (AI Agents)

- فراخوانی ابزار توسط مدل (Tool Calling)

- پروتکل Model Context Protocol (MCP)

صنعت پرداخت که طی دهههای گذشته از پول نقد به کارت و سپس به پرداخت دیجیتال تغییر مسیر داده، اکنون در آستانهی ورود به عصری است که در آن هوشمندی و خودکارسازی نقش محوری دارند.

در این میان، Model Context Protocol (MCP) به عنوان یک استاندارد نوظهور و در حال تکامل، نقش مهمی در استانداردسازی اتصال مدلهای زبانی به ابزارها و دادههای خارجی ایفا میکند و آیندهی ایجنتهای هوش مصنوعی را شکل میدهد.

در این مقاله به زبانی آموزشی و روان توضیح میدهیم که این مفاهیم چیستند، چگونه کار میکنند، و چه نقشی در تحول صنعت پرداخت و امور مالی دارند. همچنین با ارائهی مثالهای واقعی از شرکتهای معتبر مانند Visa، Mastercard، Stripe و PayPal، به کاربردهای عملی این فناوریها خواهیم پرداخت. در ادامه نگاهی به نمونههای ایرانی نیز خواهیم داشت و در پایان جمعبندی کوتاهی ارائه میکنیم.

1. مدلهای زبانی بزرگ (LLM) چیست و چگونه کار میکنند؟

مدل زبانی بزرگ (LLM) یک مدل یادگیری عمیق است که روی حجم عظیمی از متون انسانی آموزش دیده تا بتواند زبان را درک کند و متون جدید تولید کند.

ویژگیهای LLM:

- آموزش بر پایه دادههای عظیم: میلیاردها کلمه از کتابها، مقالات و وبسایتها.

- معماری پیشرفته: معمولا مبتنی بر ترنسفورمرها برای درک توالی کلمات.

- تواناییهای متنوع: از تولید متن گرفته تا ترجمه، خلاصهسازی و پاسخ به سوالات.

مثال واقعی: استفاده Mastercard از LLM برای کشف تقلب

شرکت مسترکارت مدلی مشابه GPT توسعه داده که با یادگیری از ۱۲۵ میلیارد تراکنش، الگوهای کلاهبرداری را شناسایی میکند.

این مدل نرخ شناسایی کارتهای لو رفته را دو برابر کرده و جلوی تقلب قبل از وقوع را میگیرد.

لینک خبر

یکی از مزایای اصلی استفاده از مدلهای هوش مصنوعی در اپلیکیشنها، سادهسازی فرآیند هوشمندسازی است. برخلاف تصور عموم، استفاده از این مدلها نیاز به دانش پیچیده ریاضی یا درک عمیق از الگوریتمهای هوش مصنوعی ندارد. توسعهدهندگان میتوانند با استفاده از یک مدل آماده به سادگی قابلیتهای هوشمند را به برنامههای خود اضافه کنند. به عنوان مثال، میتوان از یک مدل چتبات برای پاسخگویی خودکار به سؤالات کاربران یا از مدل تبدیل متن به تصویر برای ایجاد تصاویر بر اساس توضیحات متنی استفاده کرد. این مدلها با APIهای سادهای در دسترس هستند که به راحتی میتوان آنها را در برنامهها ادغام کرد.

نقش مهندسان ML، مهندسان پلتفرم و توسعهدهندگان اپلیکیشن

در استفاده از هوش مصنوعی و یادگیری ماشین در پروژهها، نقشهای مختلفی دخیل هستند. تصویر زیر نقشها و وظایف مختلف را نشان میدهد:

- مهندسان ML: مسئول آموزش مدل، تنظیم دقیق (Fine-Tuning) و استنتاج (Inference) مدل هستند.

- مهندسان پلتفرم: زیرساخت و پلتفرم مورد نیاز برای اجرای مدلها را فراهم میکنند.

- توسعهدهندگان اپلیکیشن: از APIهای ارائهشده برای ادغام قابلیتهای هوشمند در برنامههای خود استفاده میکنند.

استنتاج مدل از طریق APIهای HTTP

در استفاده از هوش مصنوعی در اپلیکیشنها، ارتباط بین برنامه و سرویسهای مدلسازی بسیار حیاتی است. ارتباط با مدلهای هوش مصنوعی از طریق APIهای HTTP شباهت زیادی به ارتباط با پایگاههای داده از طریق JDBC دارد؛ به این صورت که برنامهها به جای اجرای کوئریهای پایگاه داده، درخواستهایی را به سرویسهای مدلسازی ارسال میکنند. تصویر زیر نشاندهنده چگونگی استفاده از APIهای HTTP برای استنتاج مدل و ارتباط با سرویسهای پایگاه داده است:

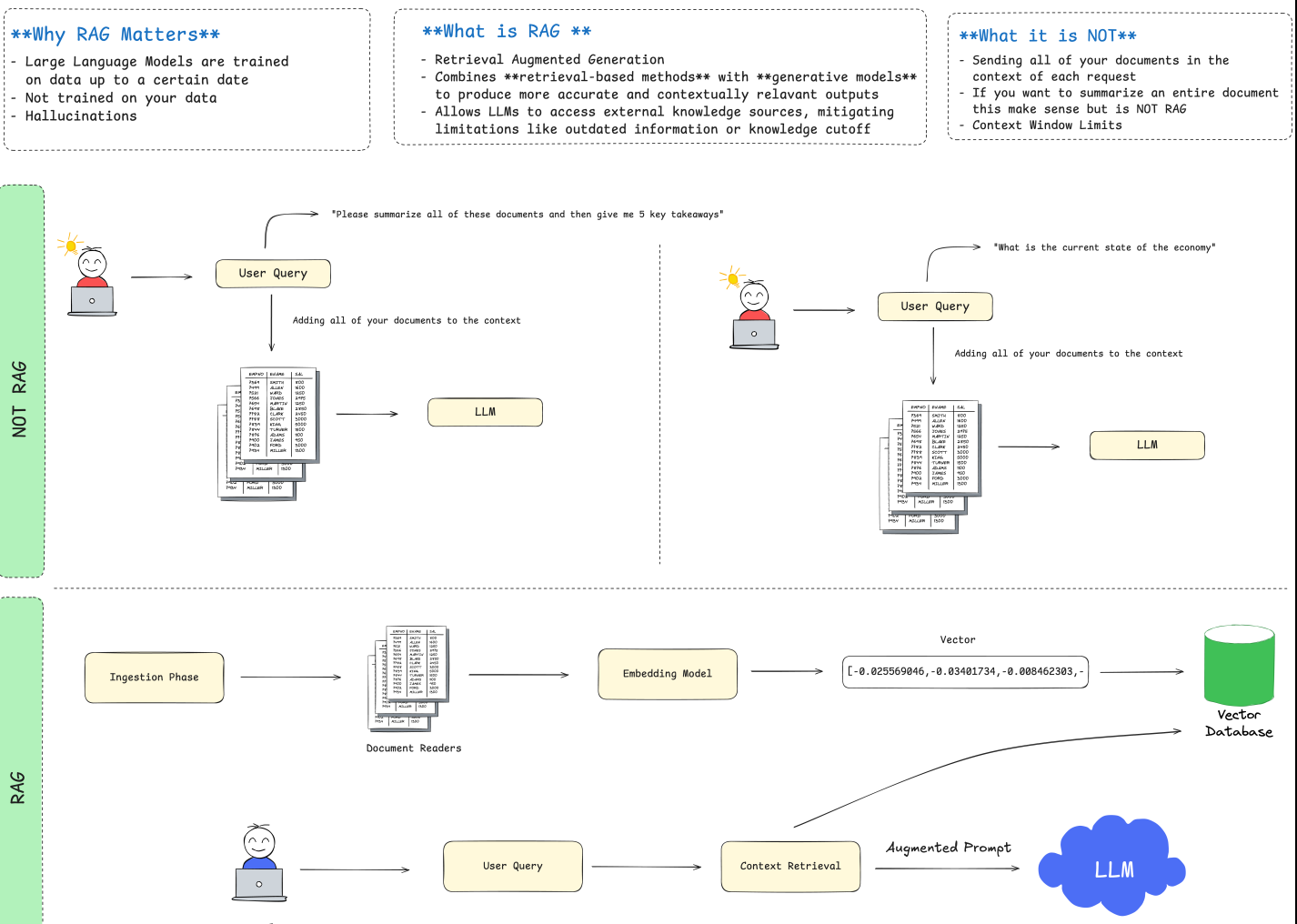

2. RAG (بازیابی و تولید ترکیبی) چیست؟

مشکل LLMها:

مدلهای زبانی فقط اطلاعاتی را میدانند که هنگام آموزش دیدهاند؛ اطلاعات جدید یا اختصاصی را نمیدانند.

راهحل: RAG

RAG (Retrieval-Augmented Generation) روشی است که مدل زبانی را به یک منبع اطلاعاتی (پایگاه داده، موتور جستجو یا ...) متصل میکند تا قبل از پاسخ دادن، مطالب مرتبط را بازیابی کند و بعد پاسخ بسازد.

فرآیند RAG:

- کاربر سوالی میپرسد

- اطلاعات مرتبط از منابع جستجو میشود

- مدل زبانی با استفاده از اطلاعات بازیابی شده پاسخ میدهد

مزایای RAG:

- دسترسی به اطلاعات بهروز

- کاهش خطای خیالپردازی مدل

- امکان سفارشیسازی پاسخها با دانش داخلی

مثال واقعی: پروژه Morgan Stanley

مورگان استنلی با کمک OpenAI سیستمی ساخته که هزاران سند تحقیقاتی مالی را بازیابی میکند و به مشاوران مالی پاسخهای دقیق و استناددار ارائه میدهد.

لینک خبر

3. ایجنتهای هوش مصنوعی (AI Agents) و Tool Calling چگونه کار میکنند؟

ایجنت هوش مصنوعی برنامهای است که میتواند به صورت خودگردان تصمیم بگیرد و اقدام کند.

در ایجنتها، مدل زبانی بزرگ (LLM) نقش «مغز متفکر» را بازی میکند و ابزارهای خارجی به آن کمک میکنند کارها را انجام دهد.

یکی از مهمترین قابلیتهای ایجنتها، استفاده از Tool Calling برای دسترسی به اطلاعات و انجام عملیات است.

اجزای اصلی یک AI Agent:

- مدل زبانی (LLM) برای درک، تصمیمگیری و تولید پاسخ

- دسترسی به ابزارها و سرویسهای خارجی

(مثل: API جستجوی وب، ماشین حساب، بانک اطلاعاتی، سرویسهای ایمیل، نقشهها و پرداختها) - حلقه بازخورد و اصلاح خودکار برای بهبود مداوم عملکرد ایجنت

Tool Calling (فراخوانی ابزار توسط مدل) چیست؟

مدلهای زبانی به تنهایی محدودیتهایی دارند؛ آنها نمیتوانند مستقیم به اینترنت وصل شوند یا محاسبات خاص انجام دهند.

Tool Calling راهکاری است که به مدلها اجازه میدهد در زمان پاسخگویی، به یک ابزار خارجی متصل شوند و اطلاعات لازم را دریافت یا اقدامات مشخصی را انجام دهند.

مزایای Tool Calling:

- دسترسی به اطلاعات زنده و بهروز

- انجام اقدامات عملی مثل استعلام موجودی حساب یا رزرو بلیت

- افزایش دقت و کارایی پاسخها فراتر از دانش مدل

ارتباط Tool Calling با APIها:

ایجنتها برای فراخوانی ابزارها، از API استفاده میکنند.

مثلاً میتوانند به یک API پرداخت، API اطلاعات آبوهوا، یا API مدیریت ایمیل متصل شوند تا نیاز کاربر را پاسخ دهند.

مثالهای واقعی از ایجنتهای هوش مصنوعی و Tool Calling

درک بهتر کاربرد ایجنتها و Tool Calling با مثالهای واقعی سادهتر میشود.

بیایید چند سناریوی واقعی را بررسی کنیم:

- یک سناریوی متداول در اپلیکیشنهای مالی

فرض کنید شما در یک اپلیکیشن مالی، از یک چتبات هوشمند میپرسید:

«لطفا مجموع تراکش های هفتهی گذشتهام را محاسبه کن.»

در اینجا چه اتفاقی میافتد؟

- مدل زبانی (LLM) درک میکند که نیاز به دسترسی به تراکنشهای مالی هفتهی گذشته شما دارد.

- مدل از طریق Tool Calling به API تراکنشهای بانکی متصل میشود.

- لیست تراکنشهای شما را دریافت میکند.

- مجموع تراکنش ها را محاسبه کرده و پاسخ نهایی را به صورت طبیعی به شما اعلام میکند.

✅ تمام این فرایند در پسزمینه اتفاق میافتد و کاربر فقط یک پاسخ دقیق و سریع دریافت میکند.

- دستیار هوشمند PayPal

یکی از نمونههای عملی و موفق استفاده از Tool Calling، دستیار PayPal Assistant است.

اگر از دستیار بپرسید:

«وضعیت پرداخت فلان چیست؟»

- دستیار به طور خودکار از طریق Tool Calling به سیستمهای داخلی PayPal متصل میشود.

- اطلاعات مربوط به تراکنش موردنظر را واکشی میکند.

- به زبان طبیعی جواب میدهد.

اگر درخواست کنید:

«آن تراکنش را به عنوان کلاهبرداری گزارش کن.»

- دستیار ابزار مرتبط را فراخوانی میکند.

- تراکنش را علامتگذاری و فرایند بررسی را آغاز میکند.

این دستیار با استفاده از هوش مصنوعی مولد (Generative AI) به مرور زمان از مکالمات کاربران یاد میگیرد و پاسخهایش بهینهتر میشود.

مشاهده منبع

- اتصال Bard گوگل به سرویسهای خارجی

Bard، چتبات گوگل، نمونهی دیگری از استفاده از Tool Calling در مقیاس بزرگ است:

- Bard میتواند از طریق APIهای Gmail، Google Maps و Google Docs به سرویسهای گوگل متصل شود.

- برای کاربر اطلاعات جستجو کند، ایمیلها را بازیابی کند، مسیریابی کند یا اسناد را بررسی کند.

- این اتصال باعث میشود Bard بتواند وظایف پیچیدهای را انجام دهد که فراتر از توانایی مدل زبانی به تنهایی است.

- تجربهی Stripe با استفاده از Tool Calling

Stripe، یکی از شرکتهای پیشرو در حوزه پرداخت آنلاین، نیز از ترکیب مدلهای زبانی و Tool Calling استفاده میکند:

- تیم پشتیبانی Stripe سیستمی ساخته که مدل زبانی میتواند برای پاسخ به سوالات توسعهدهندگان، اطلاعات حساب، یا کدهای نمونه را از پایگاه داده استخراج کند.

- به عنوان مثال، وقتی کاربری میپرسد:

«چطور API را برای انجام X تنظیم کنم؟»

- مدل میتواند مستندات مرتبط را پیدا کند.

- حتی ممکن است با فراخوانی ابزار داخلی، یک قطعه کد (snippet) آماده به کاربر بدهد.

این رویکرد باعث کاهش زمان پاسخدهی و بهبود تجربهی کاربری در پشتیبانی فنی شده است.

✅ همانطور که دیدیم، ترکیب مدلهای زبانی با Tool Calling، امکانات فوقالعادهای را برای ساخت ایجنتهای هوشمند و خودگردان فراهم کرده است. این ترکیب هم اطلاعات دقیقتر ارائه میدهد و هم توانایی انجام اقدامات واقعی را ممکن میسازد.

4. کاربردهای ترکیبی این فناوریها در صنعت پرداخت

ترکیب LLM، RAG، AI Agents و Tool Calling توانسته صنعت پرداخت را متحول کند:

الف. کشف تقلب و امنیت مالی

- Mastercard با مدل LLM تخصصی کشف کارتهای سرقتی را دو برابر کرده است.

- Visa بیش از ۵۰۰ ابزار مبتنی بر AI راهاندازی کرده برای مقابله با تقلبهای پیشرفته.

لینک خبر

ب. دستیارهای هوشمند برای مشتریان

- دستیارهای بانکها و شرکتهای فینتک با ترکیب RAG و Tool Calling به مشتریان خدمات سریعتر و دقیقتر ارائه میدهند.

- نمونه: PayPal Assistant، Erica بانک آمریکا

ج. ارتقاء تجربه توسعهدهندگان

- Stripe از GPT-4 برای پاسخگویی به سوالات فنی توسعهدهندگان و ارائه کدهای نمونه استفاده میکند.

لینک خبر

د. مدیریت ریسک و تصمیمات اعتباری

- مدلهای LLM با اتصال به پایگاههای دادهی مالی، به مؤسسات کمک میکنند سریعتر و دقیقتر تصمیمات اعتباری بگیرند.

5. پروژههای نمونه در ایران

الف. دستیار هوشمند بانک ملت

بانک ملت با تأسیس «مؤسسه هوش مصنوعی و فناوریهای شناختی»، توسعه یک دستیار هوشمند بانکی را آغاز کرده است.

این دستیار با استفاده از LLM، خدمات پشتیبانی و مشاوره را از طریق سایت و اپلیکیشن بانک ارائه میدهد و در آینده میتواند عملیات بانکی را هم انجام دهد.

لینک خبر

ب. چتبات هوشمند بانک ملی در پیامرسان بله

بانک ملی در پیامرسان بله دستیار هوش مصنوعی مبتنی بر ChatGPT-4o را راهاندازی کرده که کاربران بدون VPN میتوانند از آن استفاده کنند.

این چتبات خدماتی مانند تولید محتوا، پاسخ به سوالات، ترجمه متن و حتی تولید تصویر بر اساس متن را ارائه میدهد.

لینک خبر

ج. دانابات – چتبات هوشمند فارسی

دانابات محصول مرکز تحقیقات پارت است؛ یک چتبات هوشمند فارسی که با استفاده از RAG و LLM بومی شده، پاسخهای دقیق و مستند به سؤالات پرتکرار مشتریان بانکها و شرکتهای پرداخت میدهد.

هدف آن کاهش حجم کاری تیمهای پشتیبانی و ارتقاء کیفیت پاسخدهی است.

لینک خبر

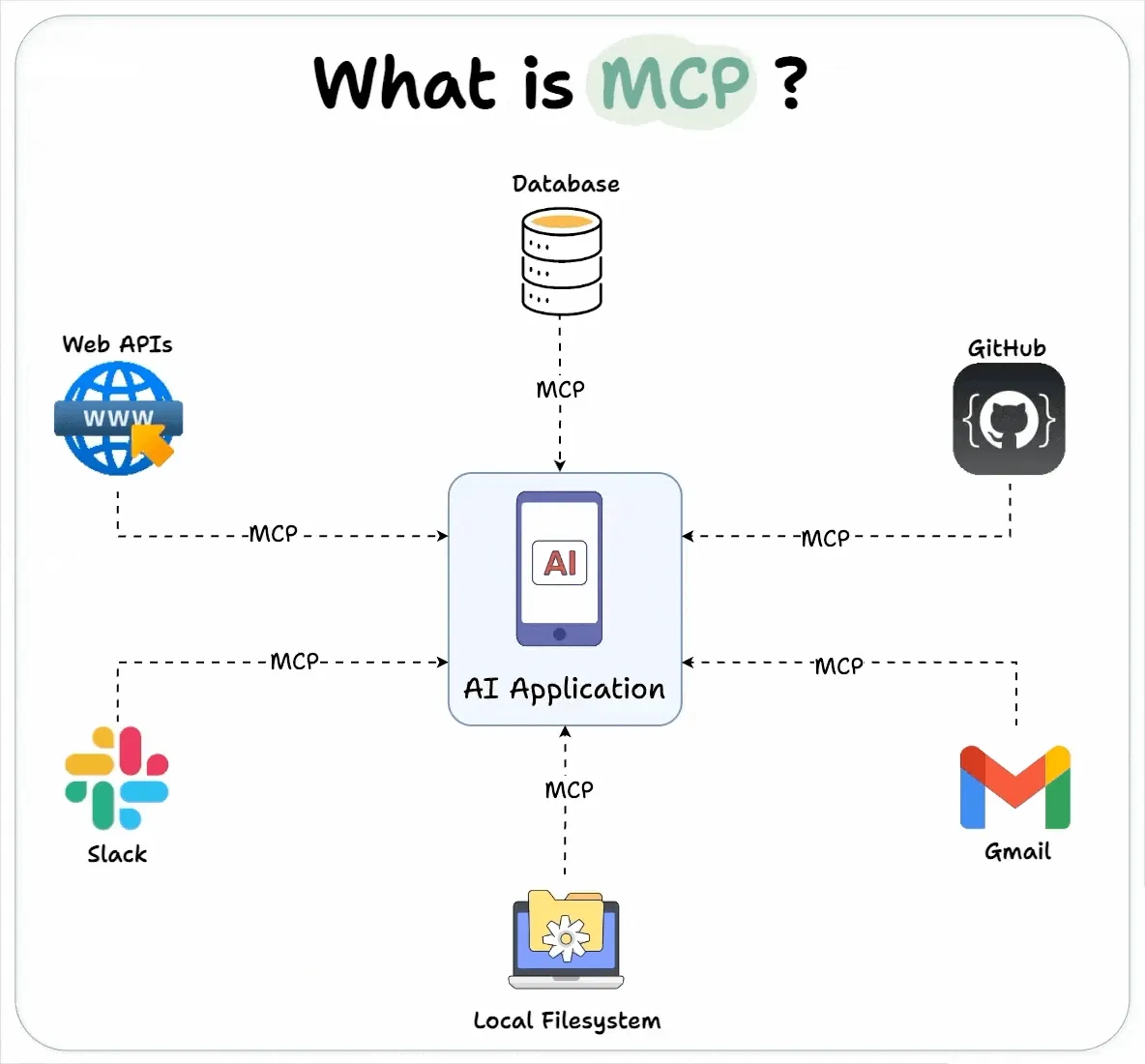

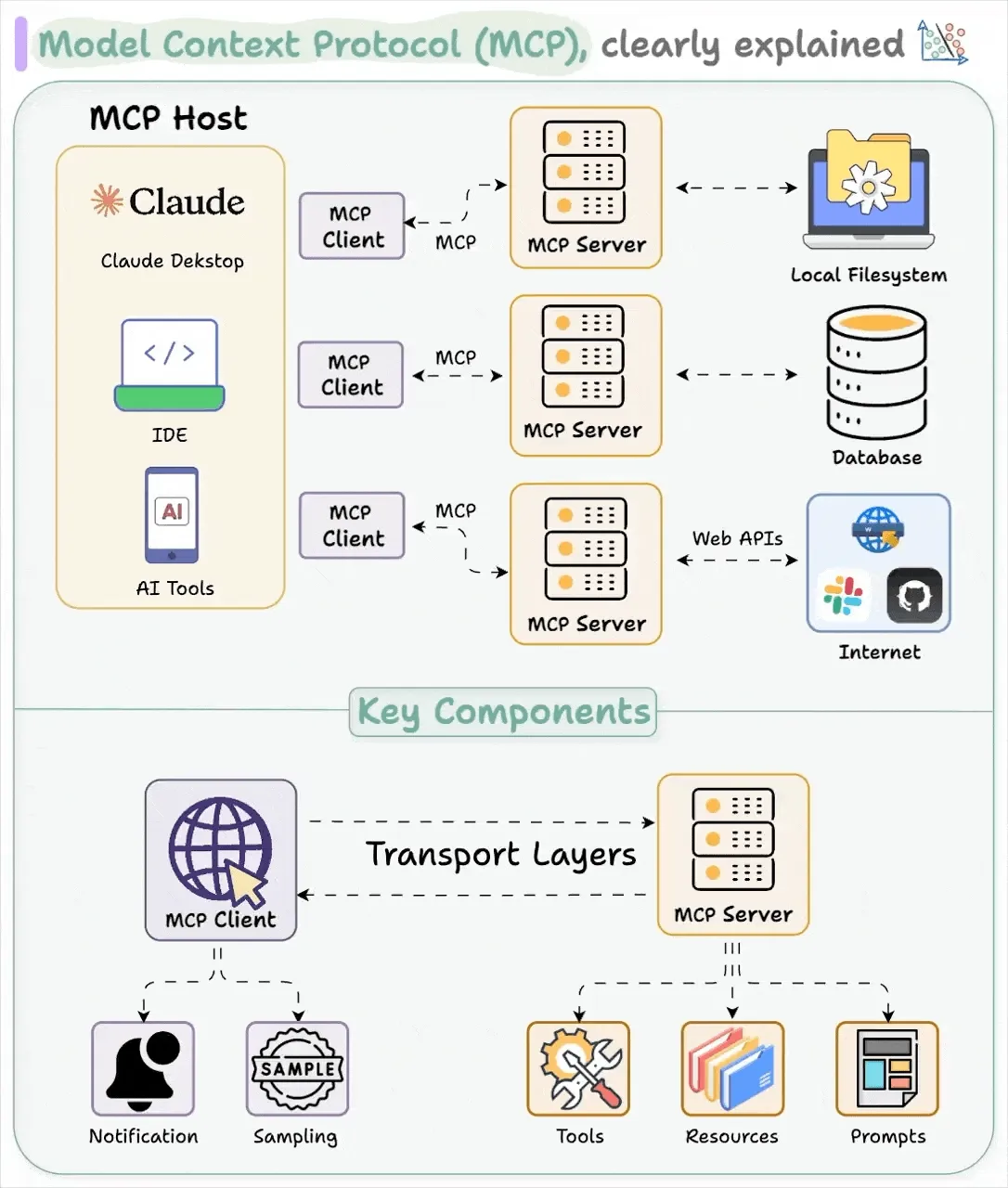

7. آشنایی با Model Context Protocol (MCP)

یکی از فناوریهای نوینی که به تکمیل قابلیتهای ایجنتهای هوش مصنوعی و Tool Calling کمک میکند، Model Context Protocol (MCP) است.

MCP یک استاندارد باز است که برای اتصال مدلهای زبانی بزرگ (LLM) به منابع داده و سرویسهای خارجی طراحی شده است. این پروتکل نقش پلی میان مدلهای هوش مصنوعی و دنیای بیرون را ایفا میکند و امکان دریافت دادههای زنده، انجام عملیات واقعی و ارتقاء کیفیت پاسخها را فراهم میسازد. به بیان ساده، MCP مانند یک درگاه استاندارد عمل میکند که مدلها میتوانند از طریق آن به انواع پایگاههای داده، APIها و ابزارهای خارجی متصل شوند.

ارتباط MCP با Tool Calling و ایجنتهای هوش مصنوعی بسیار مستقیم است. با استفاده از MCP، ایجنتها میتوانند به صورت ساختیافته و ایمن به توابع خارجی دسترسی پیدا کنند و بدون نیاز به کدنویسیهای سفارشی برای هر سرویس، ابزارها را فراخوانی کنند. این موضوع توسعهی ایجنتهای هوشمند، خودمختار و چندمرحلهای را بسیار سادهتر و سریعتر میکند.

به عنوان مثال، شرکت فینتکی Block (مالک Square) از MCP برای اتصال سامانههای هوش مصنوعی خود به پایگاههای دانش و ابزارهای داخلی استفاده کرده است. این کار باعث شده ایجنتها بتوانند عملیاتهای مرتبط با پرداخت، پشتیبانی مشتری و تحلیلهای مالی را به طور هوشمندانه و خودکار انجام دهند.

✅ به این ترتیب، MCP نقش مهمی در آیندهی ایجنتهای هوش مصنوعی و کاربردهای عملی LLMها به ویژه در صنعت پرداخت خواهد داشت.

8. جمعبندی

ترکیب فناوریهای مدلهای زبانی بزرگ (LLM)، ایجنتهای هوش مصنوعی (AI Agents)، بازیابی و تولید ترکیبی (RAG) و فراخوانی ابزار (Tool Calling)،

در حال متحولکردن دنیای پرداخت و امور مالی است.

✅ شرکتهای بزرگ دنیا مانند Visa، Mastercard، Stripe و PayPal،

✅ و بانکهای ایرانی مثل ملت و ملی،

با استفاده از این فناوریها امنیت بالاتر، خدمات سریعتر، و تجربه کاربری بهتری را ارائه میدهند.

در سالهای پیش رو، انتظار میرود این روند با شدت بیشتری ادامه یابد و تحول عمیقی در نحوهی تعامل ما با خدمات مالی ایجاد کند.